1 第一次尝试-python

最开始的设想是:

- 为了快速建模上线先做一个demo网站模板,看看效果,是不是一个好网站,这里包括如下内容:

- 公司:建立公司数据源

- 产品:建立产品数据源

- 模型:建立内部模型库

- 事件:用公司、产品、模型追踪大公司时间,存储每天每周重要事件

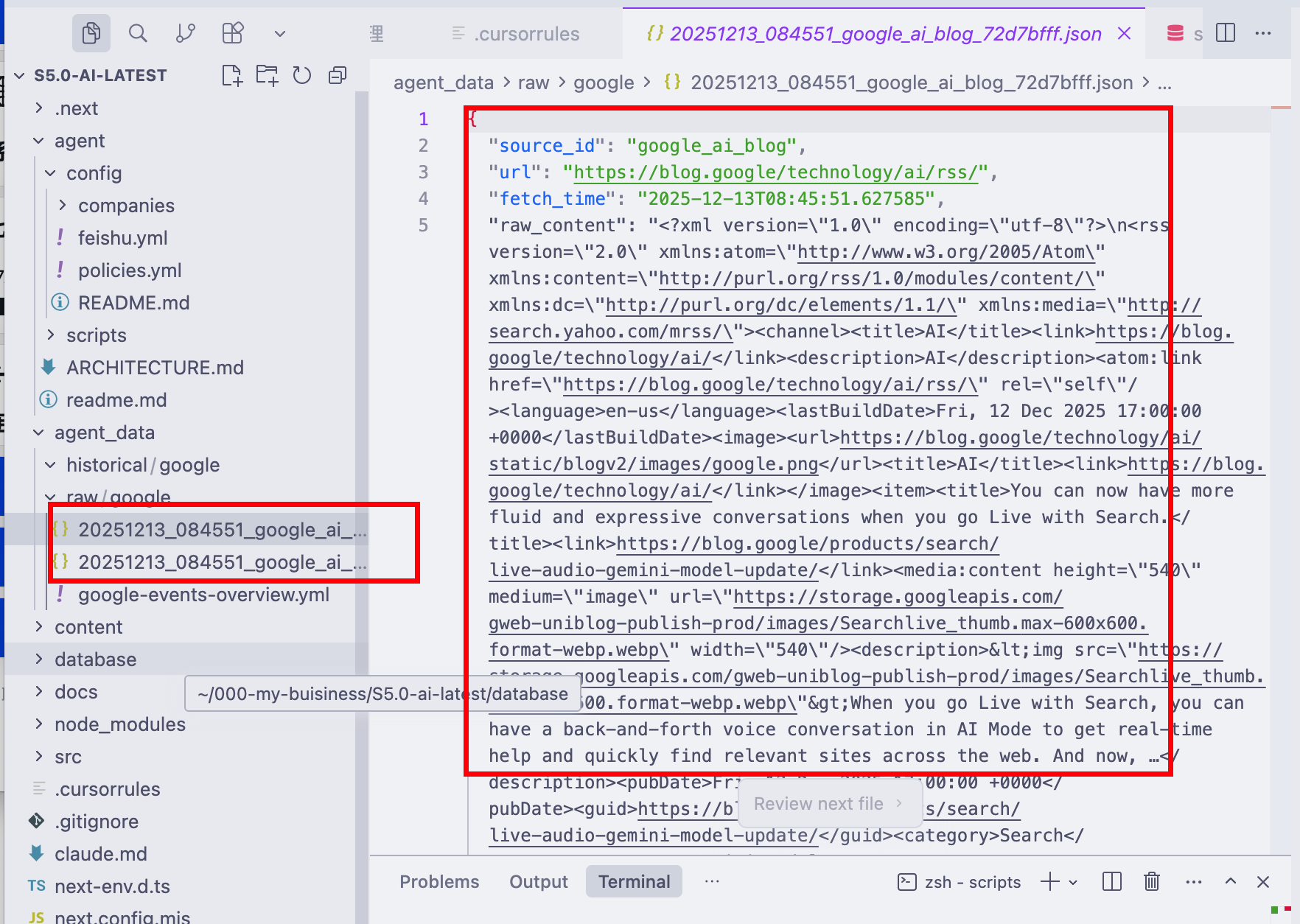

- 快速用python爬取处理建立的信息集合,然后写爬虫或者rss订阅相关数据

虽然能快速生效查询到这些结果,但是我发现这不是一个合格的工作流:

- 文档很杂乱,每个公司每年都有太多事件,分析和处理这些事件都不换算

- 大模型本身的数据集有限,可以很好的过滤,但是近期一年的事件都没有

- 适用python存储的原始网页、数据都没有什么意义,后续还是需要大模型进一步分析,后续还是体力活多

- 不能形成一个有效的sop,后续做自动化开放量还是不少。

再进一步分析这里有如下问题:

- 数据采集、数据过滤、数据加工、数据展示其实是一个职责分明的工作,每个功能都有自己的职责,用python脚本可以做好采集或者过滤或者加工,但是强行把他们结合汇总很麻烦——不是职责单一的设计,也不便于未来丰富的拓展需求。

- 数据过滤和数据加工本身如果有轮子就不建议自己造,大模型就属于自己造轮子